Kategoria

Aktualności

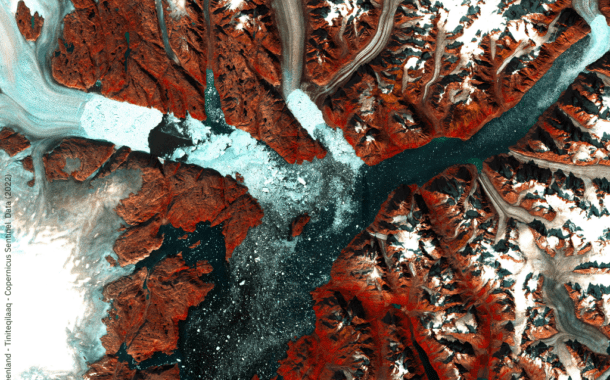

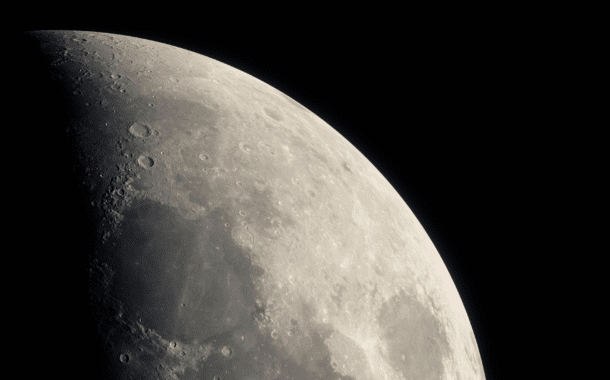

Sławosz Uznański: To było moje marzenie, od kiedy byłem małym chłopcem!

02.12.2022 9 min czytania

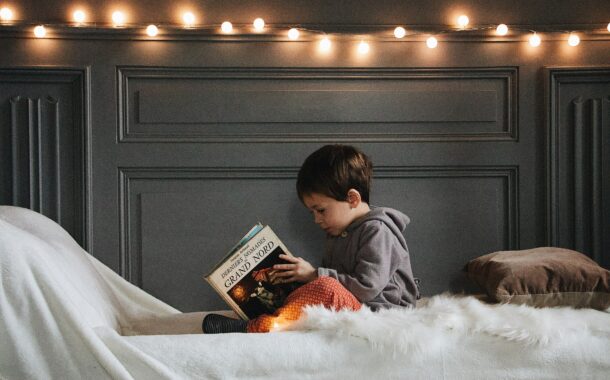

Sara Olszewska: „Zadaniem ilustratora jest zaczarować dziecko”

25.11.2022 3 min czytania

Biodruk 3D: Bioniczna trzustka szansą dla tysięcy chorych. Polacy pracują nad rewolucją

12.11.2022 8 min czytania

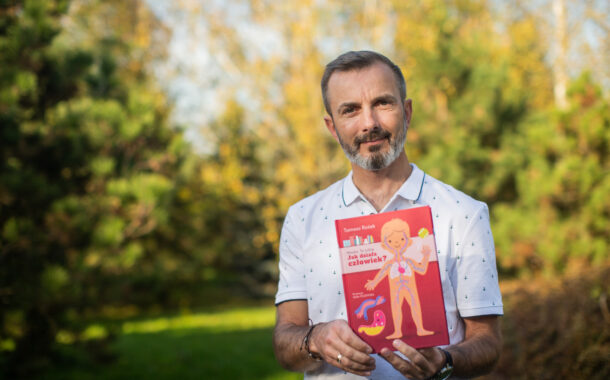

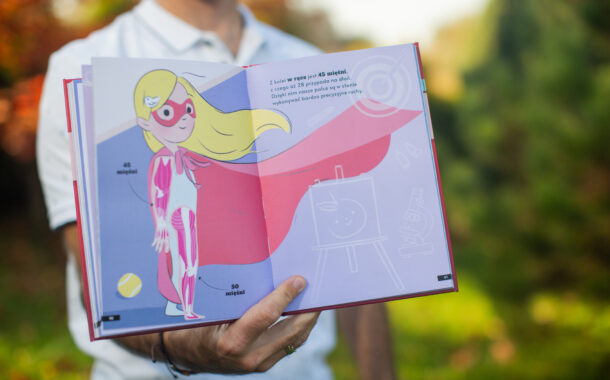

„Tak działa człowiek” zeszyt zabaw z zagadkami i ciekawostkami o ludzkim ciele

05.11.2022 2 min czytania

Rękawica tłumacząca język migowy ułatwi komunikację z osobami niemymi

23.10.2022 2 min czytania

Krótkowzroczność to nie wyrok – wywiad z optometrystką Sylwią Kijewską

11.10.2022 7 min czytania