Tag

życie

Czym jest bitcoin i jak działa?

24.03.2022 00:10:26

Widziałeś billboard z żarówką? Mój komentarz

10.02.2022 10:44

Billboardy z żarówką manipulują przekazem

10.02.2022 00:10:44

Czy grozi nam blackout?

05.01.2022 00:12:50

Dlaczego prąd drożeje?

02.12.2021 00:08:52

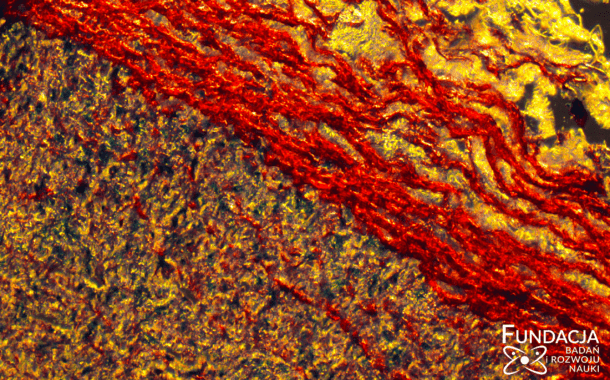

Kiedy umiera człowiek?

28.10.2021 11:10

Najbardziej cieszą nas zielone

26.02.2019 4 min czytania